© Patrick Pollmeier / Universität Bremen

Unsere Mitglieder sind an einer Vielzahl spannender Forschungsprojekte im Bereich Minds, Media, Machines beteiligt. Hier stellen wir nur einige der jüngsten Kooperationsprojekte vor. Für weitere Informationen folgen Sie bitte den jeweiligen Links und besuchen Sie unsere Mitgliederseite.

Der Wissenschaftsschwerpunkt Minds, Media, Machines ist Teil des gemeinsamen „Joint Research Center on Cooperative and Cognition-enabled AI” (CoAI JRC) der Wissenschaftsstandpunkte Bielefeld, Bremen und Paderborn. Unser Wissenschaftsschwerpunkt steht dabei zentral für den Bremer Standort des Forschungszentrums.

Sprecher:innen: Prof. Dr. Philipp Cimiano, Prof. Dr. Michael Beetz, Prof. Dr. Rohlfing

Fördergeber: Universität Bremen, Universität Bielefeld, Universität Paderborn

Eine verantwortungsvolle, auf den Menschen ausgerichtete KI braucht einen Weg, um mit Bedeutung umzugehen. Das MUHAI-Projekt befasst sich mit dieser grundlegenden Frage, indem es computergestützte Modelle für die Konstruktion von Erzählungen entwickelt.

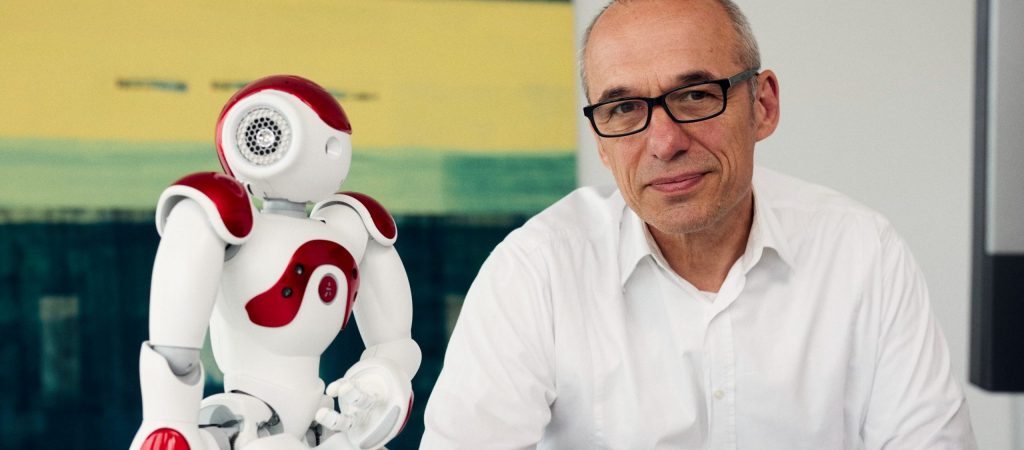

Koordinator: Prof. Dr. Rainer Malaka

Fördergeber: EU Horizon 2020 (No. 951846)

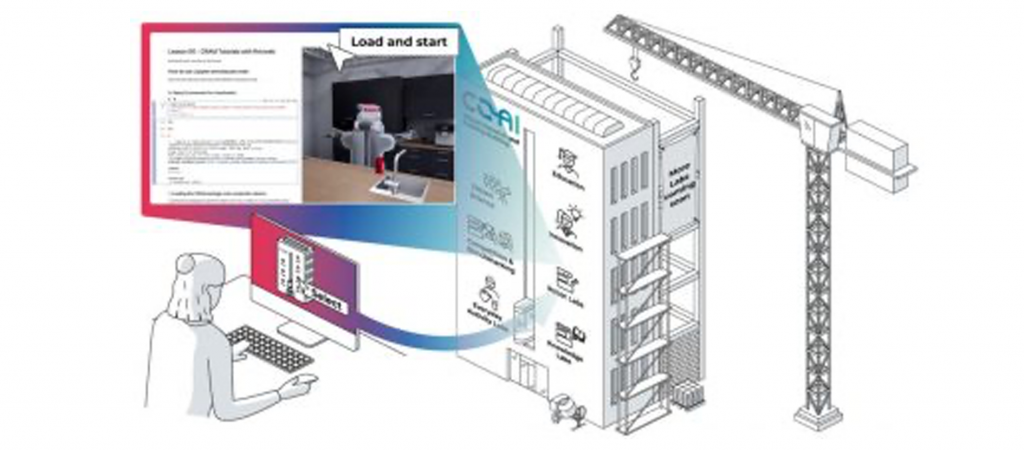

IntEL4CoRo nutzt den Ansatz des kompetenzorientierten Unterrichts, um Studierende in die Lage zu versetzen, ihr Wissen anzuwenden und selbstständig weiterzuentwickeln. So sollen sich die Studierenden intensiv mit Steuerungssystemen für Roboter und physikalischen Simulationen beschäftigen.

Koordinator: Prof. Dr. Michael Beetz, Dr. Yildray Ogurol

Fördergeber: BMBF

Im Graduiertenkolleg π³ konzentrieren sich die Doktorand:innen an der Schnittstelle zwischen angewandter Mathematik und Informatik auf Fragen der Parameteridentifikation, die im Wesentlichen als hochdimensionale Minimierungsprobleme für geeignete Funktionale formuliert werden.

Sprecher:innen: Prof. Dr. Peter Maaß

Fördergeber: Prof. Dr. Christof Büskens, Prof. Dr. Thorsten Dickhaus

EASE ist ein interdisziplinäres Forschungszentrum an der Universität Bremen, das alltägliche Aktivitäten in Wissenschaft und Technik untersucht. Sein Hauptzweck besteht darin, unser Verständnis darüber zu verbessern, wie Manipulationsaufgaben im menschlichen Maßstab von Roboteragenten gemeistert werden können.

Sprecher: Prof. Dr. Michael Beetz

Fördergeber: DFG (SFB)

„Empowering Digital Media“ (EDM) folgt der Kernidee, dass Technologie dem Menschen dienen soll und nicht umgekehrt. Der Schwerpunkt der Projekte liegt auf der Entwicklung von Technologien, die es jedem ermöglichen, Computer intuitiv zu nutzen.

Sprecher: Rainer Malaka

Fördergeber: Klaus Schira Stiftung

Das Zusammenspiel zwischen wirtschaftlicher Entscheidungsfindung und Systemdesign steht im Mittelpunkt der KD²School, da es die Grundlagen für die Umwandlung statischer Systeme in dynamische, adaptive Systeme schafft.

Sprecher:innen: Prof. Dr. Christof Weinhard (KIT), Prof. Dr. Tanja Schultz

Fördergeber: DFG (Research Training Group)

Ziel des AI4HRI-Projekts ist es, verschiedene KI-Methoden zu entwickeln und zu integrieren, die es sozialen Robotern ermöglichen, angemessen mit Menschen umzugehen.

MMM-PI: Prof. Dr. Michael Beetz

Fördergeber: DFG

The massive influx of health data in combination with recent advancements in artificial intelligence holds great potential to transform the health sciences. In LifeSpanAI, we envision to advance AI methods and tools to model, predict, and explain health outcomes from multi-dimensional data that span the entire life.

Sprecher:innen: Prof. Dr. Tanja Schultz , Prof. Dr, Marvin N. Wright

Fördergeber: DFG (Forschergruppe)

Das Cognitive Systems Lab hat LabLinking (LL) entwickelt, ein experimentelles System, das gemeinsame Experimente aus der Ferne ohne physische Einschränkungen ermöglicht. Der Schwerpunkt liegt auf der Bewegungsanalyse, die in verschiedenen Bereichen wie der Kunst, der Industrie und bei täglichen Aktivitäten eingesetzt werden kann.

Kontaktpersonen: Felix Putze und Tanja Schultz

Fördergeber: Hanse Wissenschaftskolleg (HWK)

Die Bremen Big Data Challenge ist der jährliche Datenanalyse-Wettbewerb des Cognitive Systems Lab an der Universität Bremen. Die Teilnehmerinnen und Teilnehmer wetteifern den ganzen März über um ein Preisgeld von 1500 Euro und attraktive Sachpreise. Ein konkretes Ziel für das kommende Jahr ist die Einführung der BBDC an Bremer Schulen. Mit seinem Schwerpunkt auf kreativem und aktivem Lernen durch Aufgaben und Teamarbeit eignet sich das Format hervorragend für Schülerinnen und Schüler der Oberstufe und bietet ihnen viele Möglichkeiten, etwas über Big Data und Maschinelles Lernen zu lernen, und nur bei Interesse und Bedarf in die Tiefe einzusteigen.

Kontaktpersonen: Tanja Schultz

Sponsoren: Just Add AI, Neuland – Büro für Informatik, and Sparkasse Bremen.

Das DFG-geförderte Graduiertenkolleg HEARAZ widmet sich der inter- und transdisziplinären Ausbildung und Forschung im Bereich der ohrnahen Sensorik. Ziel ist es, die Anwendung von Biosensoren zur Erkennung und Kompensation alters-assoziierter Funktionseinschränkungen umfassend zu erforschen und innovative technische Assistenzsysteme zu entwickeln.

Kontaktpersonen: Tanja Schultz

Fördergeber: DFG (Research Training Group)

MMM unterstützt regelmäßig die gemeinsamen Bemühungen seiner Mitglieder, ihr Netzwerk an Kooperationen innerhalb des Forschungsbereichs sowie die Nachhaltigkeit in der MMM-Forschung auszubauen.

MMM Investigator Seed-Grants zielen darauf ab, neue Kooperationen zwischen MMM-Mitgliedern zu unterstützen, die als Grundlage für neue gemeinsame drittmittelfinanzierte Forschungsanträge (z.B. DFG) im thematischen Fokus des MMM dienen sollen. Die gemeinsame Arbeit soll die Verbindungen und gemeinsamen Forschungsschwerpunkte zwischen den Arbeitsgruppen der Minds, Media and Machines High Profile Area weiter stärken. MMM Investigator Seed-Grants richten sich an Teams unter der Leitung von mindestens zwei MMM-Mitgliedern, die ein neues Forschungsprojekt zur Vorbereitung einer ambitionierten gemeinsamen Forschungslinie durchführen werden. Bewerbungen von MMM-Teams aus verschiedenen Disziplinen sind besonders erwünscht, aber keine Voraussetzung.

Die Bewerbungen für die Förderperiode können per E-Mail an mmm@uni-bremen.de eingereicht werden. Es gibt eine rolling deadline. Die verfügbaren Mittel werden nach dem Datum der Einreichung vergeben. Weitere Einzelheiten entnehmen Sie bitte unserem Antragsformular.

MMM Impulse Seed-Grants zielen darauf ab, neue Kooperationen zwischen MMM-AGs für spezifische Forschungsideen in einem leichtgewichtigen Verfahren zu unterstützen. Angestrebtes Ergebnis dieser Maßnahme sind gemeinsame Publikationen, die die Verbindungen und gemeinsamen Forschungsschwerpunkte zwischen den Arbeitsgruppen der Minds, Media and Machines High Profile Area weiter stärken. Während die Investigator Seed-Grants darauf abzielen, konkrete Vorhaben für gemeinsame Drittmittelprojekte zu unterstützen, fokussieren die Impulse See-Grants auf das Potenzial kleinerer Vorbereitungsprojekte zwischen Partnern, die zum ersten Mal zusammenarbeiten, um die Basis für ein größeres gemeinsames Projekt zu definieren. MMM Impulse Seed-Grants sollen von Teams aus mindestens zwei MMM AGs geleitet werden, die exzellente Forschung betreiben, um eine ambitionierte neue gemeinsame Forschungslinie zu definieren. Bewerbungen von MMM-Teams unterschiedlicher Fachrichtungen sind besonders erwünscht, aber keine Bedingung. Der Höchstbetrag für diese Impulsfinanzierung beträgt 10.000 EUR pro AG und Investigator Seed-Grant.

Die Bewerbungen für die Förderperiode 2024 können per E-Mail an mmm@uni-bremen.de eingereicht werden. Es gibt eine rolling deadline. Die verfügbaren Mittel werden nach dem Datum der Einreichung vergeben. Weitere Einzelheiten entnehmen Sie bitte unserem Antragsformular.

Für einen tieferen Einblick in die Forschungsthemen von MMM lohnt sich das Gespräch mit unseren Mitgliedern. An dieser Stelle haben wir kürzlich beispielhaft Prof. Marvin Wright interviewt, der uns zahlreiche interessante Fragen beantworten konnte. Wir danken ihm für das Gespräch!

Durch die Digitalisierung unseres Alltags, aber auch Dank wichtiger technischer Innovationen in der medizinischen Forschung wie z.B. in der Bildgebung, nimmt die Menge an Gesundheitsdaten massiv und stetig zu. Dies bietet fantastische Chancen, Krankheiten in Zukunft besser zu verstehen und sehr viel schneller und sicherer zu erkennen. Aufgrund ihrer Struktur, Größe oder Komplexität sind diese Daten jedoch mit herkömmlichen Methoden der Datenverarbeitung oft schwer zu analysieren. KI-Methoden wie maschinelles Lernen bergen hier großes Potenzial. Gleichzeitig sind die Ergebnisse und Modelle maschineller Lernverfahren jedoch oft nur schwer erklär- und interpretierbar.

Prof. Dr. Marvin Wright ist Professor für Maschinelles Lernen in der Statistik an der Universität Bremen und Leiter der Emmy Noether-Nachwuchsgruppe „Beyond Prediction – Statistical Inference with Machine Learning“ am Leibniz-Institut für Präventionsforschung und Epidemiologie – BIPS. Er forscht an der Entwicklung und Interpretierbarkeit maschineller Lernverfahren, um Gesundheitsdaten in Zukunft besser nutzen zu können.

Lieber Herr Wright, Sie sind jetzt seit zweieinhalb Jahren Professor an der Universität Bremen und am BIPS. Vorneweg: Wie haben Sie diese erste Zeit als Professor erlebt und wie sieht Ihr Berufsalltag aus?

Anfangs war es sehr stressig. Ich glaube das sagt jeder, der eine neue Professur anfängt, allein schon, weil ganz viele neue Aufgaben und neue Verantwortungen auf einen zukommen: Viele Dinge, wie zum Beispiel die Vorbereitung von Lehrveranstaltungen, bedeuten gerade zu Beginn besonders viel Arbeit. In ganz viele andere Aufgaben muss man auch erst hereinwachsen. Dazu kommt noch, dass mein Anfang in der Corona-Zeit lag. Ich habe drei kleine Kinder und die Betreuung war nicht immer zuverlässig. Jede Woche musste man erstmal schauen: wie plant man eigentlich die Woche? Wenn beide Eltern arbeiten, ist es herausfordernd Kinderbetreuung und Arbeit zu vereinen.

Aber aufregend ist es natürlich auch, viele Sachen das erste Mal zu tun und neue Aufgaben zu bekommen. Durch die Emmy Noether-Förderung habe ich die Möglichkeit, sehr selbstständig und unabhängig zu forschen. Selbst zu forschen ist mir wichtig. Und damit meine ich wirklich, selbst zu programmieren, mir Konzepte zu überlegen und Lösungen zu entwickeln.

Im Arbeitsalltag liegen die Hauptaufgaben in der Forschung, der Betreuung der Promovierenden und in der Lehre, auch wenn ich durch meine Kooperationsprofessur zwischen der Universität Bremen und dem BIPS eine reduzierte Lehrverpflichtung habe.

Stichwort Kooperationsprofessur. Wie kann man sich das vorstellen?

Das Besondere an einer Kooperationsprofessur ist, dass man gemeinsam von einer Universität und einem außeruniversitären Forschungsinstitut berufen wurde und dann an beiden Einrichtungen arbeitet: Mein Hauptarbeitsort ist das außeruniversitäre Institut, in meinem Fall das Leibniz-Institut BIPS. Hier forsche ich hauptsächlich. Ich arbeite auch an der Uni. Dort habe ich alle Rechte und Pflichten eines normalen Universitätsprofessors. Das heißt, ich habe das Recht, mich an der Universität in Lehre, Kommissionen und Prüfungsausschüssen.

Inwiefern war denn der Wissenschaftsstandort Bremen und auch die Anbindung an den Wissenschaftsschwerpunkt Minds, Media, Machines (MMM) ausschlaggebend für Ihre Entscheidung, nach Einwerbung Ihrer Emmy Noether-Nachwuchsgruppe in Bremen zu bleiben?

Einerseits fühle ich mich hier am BIPS sehr wohl. Mir gefällt, dass wir so nah an der Anwendung in den Gesundheitswissenschaften sind, aber trotzdem methodische Forschung machen können. Über das BIPS hinaus und besonders in Bezug auf Minds, Media, Machines finde ich am Standort Bremen schön, dass so viel zusammengearbeitet wird. Ich beteilige mich zum Beispiel an der Initiative „AI in Health“ und dem „AI Center in Healthcare“. Hier arbeiten verschiedene außeruniversitäre und universitäre Partner gemeinsam an einem Thema. Die gute Zusammenarbeit hat nicht nur etwas mit der Größe des Standorts zu tun, sondern vor allem auch mit seiner Kultur. Durch die erfolgreiche Zusammenarbeit des BIPS mit der Uni und seinen WSPs MMM (und Health) ist es uns gelungen, die DFG KI-Forschungsgruppe Lifespan AI einzuwerben. Durch diese Forschungsgruppe durften wir meine Brückenprofessur einrichten.

Als Leiter der Emmy Noether-Nachwuchsgruppe „Beyond Prediction – Statistical Inference with Machine Learning“ und Co-Sprecher der DFG Forschergruppe „Lifespan AI“ entwickeln Sie statistische Methoden für maschinelle Lernverfahren. Was sind aus Ihrer Sicht besondere Herausforderungen in der Modellierung von Gesundheitsdaten über die Lebensspanne?

Grundsätzlich ist im Umgang mit Gesundheitsdaten natürlich der Datenschutz eine große Herausforderung. Es geht um personenbezogene Daten, die den Menschen selbst gehören. Diese sollte man nicht einfach komplett öffentlich machen, sondern schützen. Es gibt aber auch einen Trade-off: Wenn man zu strenge Datenschutzanforderungen hat, dann kann das die Forschung bremsen. So kommt man eventuell nicht so schnell zu Erkenntnissen oder man kann Daten aus verschiedenen Quellen nicht zusammenbringen. In Deutschland ist es zum Beispiel typisch, dass verschiedene Datenquellen keine „Unique Identifier“ (deutsch: eindeutige Bezeichner) haben. Ein solcher Identifier würde es erlauben, anonymisierte Krankenkassendaten mit ebenfalls anonymisierten Impfdaten zu verknüpfen. Da man aber nicht weiß, welche Impfdaten zu welchen Krankenkassendaten gehören, können etwaige statistische Zusammenhänge mit diesen Daten auch nicht untersucht werden.

Eine weitere große Herausforderung ist die Zeit. In Lifespan AI wollen wir uns sehr lange Zeiträume anschauen. Die meisten Standardmethoden sind aber für eine Momentaufnahme gemacht, in der es keinen Faktor „Zeit“ gibt, sondern mit der man zu einem bestimmten Zeitpunkt eine Vorhersage für die Zukunft machen will. Außerdem sind die meisten Methoden, die den Faktor „Zeit“ berücksichtigen, häufig für sehr kleinschrittige, kurze Zeitintervalle, über eine vergleichsweise kurze Zeit optimiert. Aktienkurse wären ein typisches Beispiel für so eine Zeitreihe.

Wenn wir nun eine Studie durchführen, die über 20 Jahre läuft, sieht dies vollkommen anders aus. Aus solchen Studien bekommen wir zum Beispiel alle zwei Jahre Daten zu den Personen. In Lifespan AI wollen wir jedoch einen Schritt weiter gehen und Modellierungen über die gesamte Lebensspanne erstellen. Es gibt nur sehr wenige Studien über die gesamte Lebensspanne. Um eine breite Datenbasis nutzen zu können, führen wir diese Studien zusammen. Damit haben wir aber auch verschiedene Datenquellen, die ganz unterschiedliche Dinge messen. Auch wenn die gleichen Dinge gemessen werden, passiert dies teilweise auf anderem Wege oder mit anderen Geräten. Dann kommen neue Messverfahren dazu, andere fallen mit der Zeit weg. Das alles zu berücksichtigen erfordert viele methodische Weiterentwicklungen.

Nun war ja bisher lange ein Problem, dass wir gar nicht über so viele Gesundheitsdaten verfügen und schon gar nicht über langfristige. Wie sehen Sie den aktuellen Zustrom an solchen Gesundheitsdaten? Wie wird dieser sich weiterentwickeln? Und wie können wir vielleicht auch aus Sicht der Bremer Forschung in diesem Bereich Menschen dazu motivieren, ihre Daten zu spenden?

Ich glaube, grundsätzlich wird es immer mehr Daten geben. Ein Problem dabei ist, dass viele Daten ursprünglich für andere Zwecken erhoben wurden. Jetzt möchten wir sie aber für die Gesundheitsforschung nutzen. Wenn mein Mobilgerät meine Bewegungen erfasst, dann ist es erst mal unklar, ob diese Erfassung der Bewegung überhaupt ähnlich präzise, wie die Messung im Labor ist, um beispielsweise den Energieverbrauch des Körpers zu schätzen. Ein anderes Beispiel sind Krankenkassendaten. Oft wurden diese zu Abrechnungszwecken und nicht zu Forschungszwecken erhoben, sodass viele für die Forschung relevante Informationen dort entweder gar nicht enthalten sind oder es zumindest schwierig ist, sie abzuleiten. Wir müssen uns also bei Projekten wie Lifespan AI darauf vorbereiten, dass viele der Daten nicht aus kontrollierten Studien kommen. Aktuell ist es so, dass einerseits die Bereitschaft zur Teilnahme an gesundheitswissenschaftlichen Studien rückläufig ist, aber andererseits viele Leute im Alltag ihre Gesundsheitsdaten leichtfertig an Google, Apple und Co. herausgeben, indem sie einfach auf „Ja, akzeptieren“ klicken. Wie wir z.B. bei der Corona Warn-App sehen konnten, sind viele Menschen durchaus bereit, ihre Daten zu spenden, wenn sie (a) erkennen, dass die Spenden ihnen selbst und anderen zugutekommen, (b) die Nutzung der Daten transparent und gemacht wird und verständlich ist, und sie (c) Zugriff auf alle Komponenten (wie z.B. den Code) haben. Ich glaube, eine hilfreiche Komponente für die Forschung könnte sein, den Menschen hier entgegenzukommen und auch die Forschungsprozesse im Bereich der Gesundheitswissenschaft so weit wie möglich zu digitalisieren. Hier sollten wir helfen, ein Bewusstsein dafür zu schaffen, an wen man als Nutzer oder Patient Daten spenden kann, was mit diesen Daten passiert und von wem sie tatsächlich verantwortungsvoll genutzt werden.

Wenn Sie nun Gesundheitsdaten haben, auf die Sie maschinelles Lernen anwenden wollen, wie gehen Sie vor, um Ihre Modelle erklär- und interpretierbar zu machen?

Das ist unser Kernthema. Wir schauen uns Vorhersagemodelle an mit dem Ziel zu verstehen, wie sie eigentlich zu ihrer Vorhersage kommen. Dann versuchen wir, noch einen Schritt weiterzugehen und zu klären, wie eine Krankheit entsteht und welche die Risikofaktoren sind, die zu ihrer Entstehung führen. Dafür gibt es ganz viele verschiedene Methoden.

Die wichtigste Frage, die häufig unterschätzt wird, ist aber vielleicht: Was möchte ich wem eigentlich erklären und was erwarte ich von der Erklärung? Erklärbarkeit ist kein Selbstzweck. Es ist etwas vollkommen anderes, ob eine Bank ihrem Kunden erklären will oder muss, warum ein Kredit abgelehnt wurde, als wenn einem Patienten erklärt werden soll, wie ein genetischer Marker mit einer Krankheit zusammenhängt. Es kann sein, dass man dafür die gleichen Methoden verwendet. Es kann aber auch gut sein, dass man vollkommen unterschiedliche Methoden braucht. Daher ist sehr wichtig, dass man erstmal damit anfängt zu fragen: „Welche Frage möchte ich eigentlich beantworten?“, und dann dazu passende Methoden entweder auswählt oder neu entwickelt.

Was sind typische Fehlannahmen oder Missverständnisse, denen Sie begegnen, wenn Sie mit Fachfremden sprechen?

Meine Professur heißt ja ‚Maschinelles Lernen in der Statistik‘. Und lustigerweise sind das zwei Begriffe, die sehr unterschiedlich ankommen. Wenn ich sage, ich mache Statistik oder Biostatistik, dann denken viele Leute an Sportstatistiken oder daran, Tabellen zu erstellen, also ganz trocken und langweilig. Wenn man also auf die Frage ‚Und was machst du so?‘ mit ‚Statistik‘ antwortet, dann ist das sehr gut geeignet, wenn man nicht über die Arbeit reden will (lacht). Aber bei Maschinellem Lernen ist aktuell eher das Gegenteil der Fall. Besonders in letzter Zeit ist es ein typisches Missverständnis, dass „Maschinelles Lernen“ oft mit großen Sprachmodellen wie ChatGPT gleichgesetzt wird – die Fragen gehen jetzt also häufig in diese Richtung. Andere denken bei Maschinellem Lernen zuerst an Robotik, die ja auch in MMM eine wichtige Rolle spielt. Die wenigsten kommen aber auf die Idee, dass man damit so etwas machen kann, wie Krankheitsursachen basierend auf Gesundheitsdaten zu untersuchen

Aktuell gibt es wieder neue Vorstöße im Europäischen Parlament, EU-Richtlinien für maschinelle Lernverfahren zu definieren. Wie stehen Sie aus Ihrer Perspektive zu solchen Richtlinien, speziell auch für den Gesundheitsbereich? Würden Sie sich das wünschen?

Ich würde mir gerade für den Gesundheitsbereich wünschen, dass die Technologien vor allem für Forschungszwecke genutzt werden und dass diese Art der Nutzung grundsätzlich unterstützt und nicht eingeschränkt oder gar verhindert wird. Gleichzeitig muss man hier jedoch besonders mit unternehmerischen Interessen aufpassen. Auf der anderen Seite entwickeln Unternehmen häufig sehr hilfreiche Verfahren, beispielsweise KI-Verfahren, die die Heilungschancen für Krebs verbessern können. Dies sollte meiner Meinung nach nicht weg-reguliert werden, sondern im Gegenteil die Forschung und auch die Anwendung unterstützt werden.

In anderen Bereichen gibt es wiederum bestimmte KI-Anwendungen, die meiner Meinung nach unbedingt reguliert werden sollten. Nehmen wir zum Beispiel Nachrichten, die auf das persönliche Interesse zugeschnitten werden. Das führt dazu, dass die Nachrichten, die man bekommt, so personalisiert sind, dass sie entweder nur das bereits bestehende eigene Meinungsbild unterstützen oder, noch schlimmer, gezielt ein Meinungsbild suggeriert werden kann. Die Lösung liegt meiner Meinung nach aber nicht in der Begrenzung der Modelle, zum Beispiel auf eine bestimmte Anzahl an Parametern. Stattdessen sollte man auch wieder von der Anwendung her überlegen, im Prinzip ähnlich wie bei der Erklärbarkeit: Was möchte ich eigentlich verhindern? Man sollte also versuchen, gezielt zu regulieren. Ganz allgemein KI zu regulieren, wird nicht funktionieren.